”doc mpich2 并行计算“ 的搜索结果

讲义简要介绍采用Fortran语言和OpenMP技术进行并行计算的知识,配有视频教程,主要内容包括: 第一讲 OpenMP基础 第二讲 并行域 第三讲 OMP指令(上) 第四讲 OMP指令(下) 第五讲 THREADPRIVATE属性 第六讲 OMP并行...

并行算法的基本概念和并行模型

1 开启并行池–parpool 将以下代码存储为m文件,运行 p=parpool(3); i=1:100000; j=1:100000; Y=0; parfor i=1:100000 for j=1:1:100000 Y=Y+i+j; end end delete(p); 命令行会显示 >> test_parallel &...

作者:禅与计算机程序设计艺术 《CUDA 中的并行计算与 C++》技术博客文章 引言 1.1. 背景介绍 并行计算是一种可以利用多核处理器(CPU)和图形处理器(GPU)并行执行计算任务的技术。在当今大

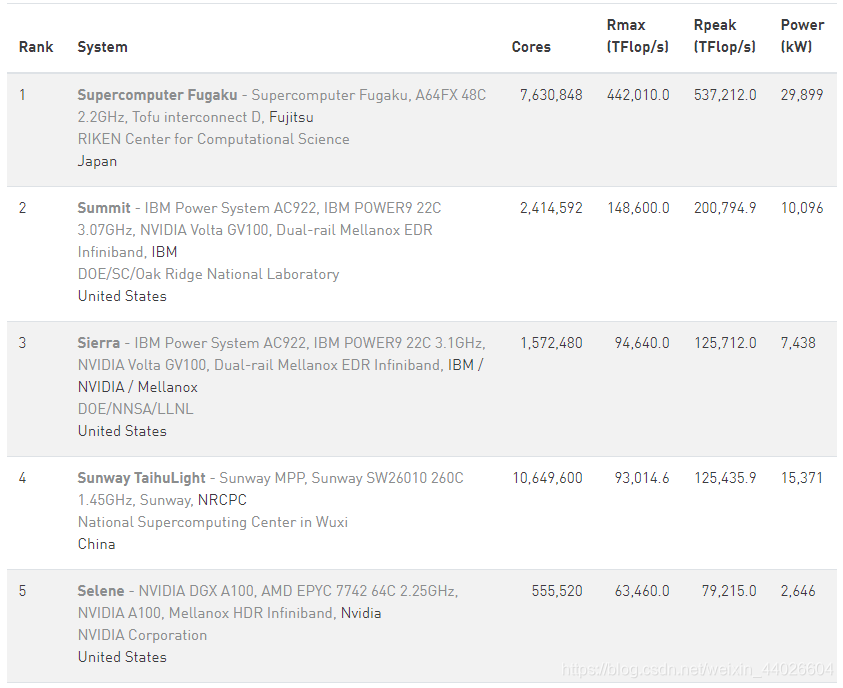

高性能期末并行计算期末考试复习提纲,主要是一些概念题、三个主要定律和三个编程题。

并行计算的算法原理:并行计算的基本思想是将一个计算任务分解为多个子任务,然后在多个处理器上并行执行,以达到更高的计算效率。并行计算的操作步骤:将计算任务分解为多个子任务;选择合适的并行计算框架;配置...

原文出处:并行计算简介 并行计算简介 (本人刚刚完成这篇长文章的翻译,尚未认真校对。若里面有翻译错误和打字错误敬请谅解,并请参考原贴) 1 摘要 最近项目需要实现程序的并行化,刚好借着翻译这篇帖子的机会...

环境:ABAQUS6.3+8 IntelXeon 700MHz CPU+4G Ram+Win2k AdvServer SP3在命令行模式下,abaqus命令的下面三个参数进行并行计算的控制:[cpus=number-of-cpus][parallel={loop | domain | supernode | tree}][domains=...

并行计算与分布式计算

标签: 大数据

关于并行计算的相关总结1. 定义2. 特征及层次3. 应用举例3.1 基于CUDA 的K-Means 多级并行优化方法3.2 面向GPU的直方图统计图像增强并行算法3.3 基于FPGA的多核可扩展卷积加速器设计 1. 定义 并行计算或称平行计算是...

并行计算、分布式计算都属于高性能计算范畴,主要目的都是对大数据进行分析和处理,都是利用并行来获得更高性能的计算——把大任务分为n个小任务。 并行计算 并行计算是相对于串行计算来说的,并行计算主要目的是...

http://blog.e-works.net.cn/514970/articles/219213.html前言:技术工程师的一项工作就是装机,看似简单,其实有时候蛮复杂的。尤其是现在,高性能计算机越来越普遍的今天,有时候安装一台机器甚至都需要跑个好几趟...

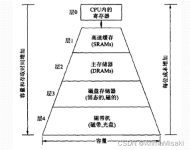

Matlab 并行计算学习 1. 简介 高性能计算(High Performance Computing,HPC)是计算机科学的一个分支,研究并行算法和开发相关软件,致力于开发高性能计算机。可见并行计算是高性能计算的不可或缺的重要组成部分。 ...

[并行计算] 1. 并行计算简介

标签: 并行计算

这篇帖子旨在为并行计算这一广泛而宏大的话题提供一个非常快速的概述,作为随后教程的先导。因此,它只涵盖了并行计算的基础知识,实用于刚刚开始熟悉该主题的初学者。

先上图,图中求500次随机矩阵...display(strcat('客户端串行计算时间:',num2str(toc),'秒')); 并行化: %% 开启线程池 if isempty(gcp('nocreate')) %如果之前没有开启parpool则启动 parpool(maxNumCompThreads);

原文转自:从串行到并行,从并行到分布式 1. 概念 假设有AB两个任务,则串行、并行、并发的区别如图1所示。 串行 A和B两个任务运行在一个CPU线程上,在A任务执行完之前不可以执行B。即,在整个程序的运行过程中...

并行计算之MPI(二)

标签: 并行计算

并行计算之MPI(一)

标签: 并行计算

基于OpenMP的并行计算 本人所有博客仅用于个人的知识积累,禁止商业与非商业用途的剽窃和抄袭,如有错误,欢迎各位大佬批评指正,一起交流讨论、共同成长。 序言:本学期选修了《GPU并行计算》这门课程,借此来...

推荐文章

- c语言链表查找成绩不及格,【查找链表面试题】面试问题:C语言学生成绩… - 看准网...-程序员宅基地

- 计算机网络:20 网络应用需求_应用对网络需求-程序员宅基地

- BEVFusion论文解读-程序员宅基地

- multisim怎么设置晶体管rbe_山东大学 模电实验 实验一:单极放大器 - 图文 --程序员宅基地

- 华为OD机试真题-灰度图恢复-2023年OD统一考试(C卷)-程序员宅基地

- 【机器学习】(周志华--西瓜书) 真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)_真正例率和假正例率,查准率,查全率,概念,区别,联系-程序员宅基地

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地